Все выходные , как и полагается вебмастеру провел за компом. Никаких развлечений — клубов, алкоголя, девочек и всего прочего, только аналитика, парсинг, оптимизация. Но самое грусное в том, что после того как несколько бессонных ночей что то делаешь, в понедельник снова возникает ощущение того, что ничего не делал. В этом плане я даже немного завидую чувакам, работающим на стройке и таскающим кирпичи. Ведь они в***ая целый день могу обернуться и посмотреть на стену, которую они построили и она завтра не исчезнет, а только вырастет. Ну вот немного поплакался теперь к главному.

Все выходные , как и полагается вебмастеру провел за компом. Никаких развлечений — клубов, алкоголя, девочек и всего прочего, только аналитика, парсинг, оптимизация. Но самое грусное в том, что после того как несколько бессонных ночей что то делаешь, в понедельник снова возникает ощущение того, что ничего не делал. В этом плане я даже немного завидую чувакам, работающим на стройке и таскающим кирпичи. Ведь они в***ая целый день могу обернуться и посмотреть на стену, которую они построили и она завтра не исчезнет, а только вырастет. Ну вот немного поплакался теперь к главному.

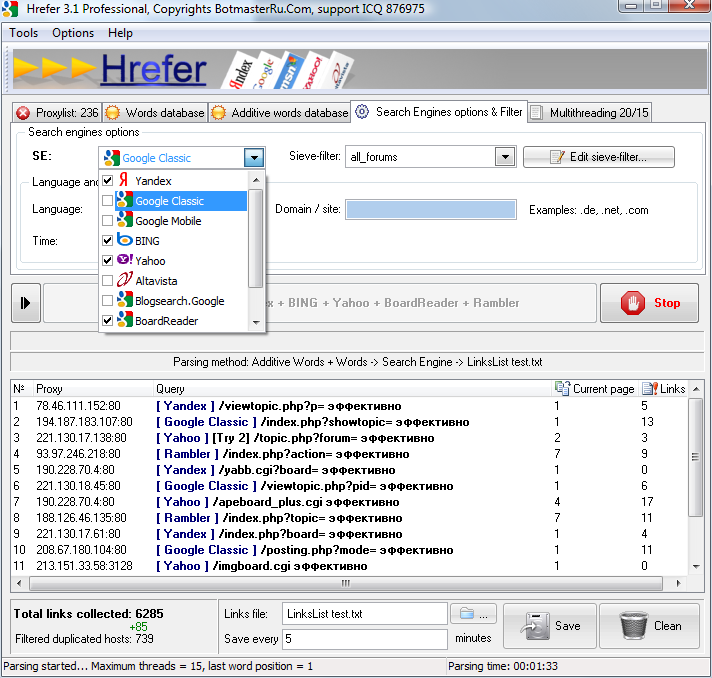

Как я уже сказал все выходные я батрачил над компом, а точнее парсил, тестил и снова парсил. Все эти манипуляции в вытаскиеванием полезных ресурсов из поисковых систем я осуществляю в помощью программы (как вы наверное уже догадались ) Xrefer. Которая идет вместе с хрумкой.

Немного выдержки с офф сайта ботмастера:

Hrefer — программа, предназначенная для поиска новых ссылок на форумы, гостевые книги, блоги, Wiki и т.п.

В общем вот такая полезная программа. На самом деле умеет парсить кучу всего и очень гибко настраивается благодаря шаблонам парсинга. Поясню. В хрефере есть специальный файлик, который отвечает за то, по каким правилам будут парситься ПС. Этот файлик, доступен для редактирования, а так же к нему написана справка. Так что при смене алгоритма можно самому быстро отредактировать шаблон парсига, а не ждать пока выйдет новая версия хрумака с актуальным шаблоном парсинга. К тому же на закрытом форуме ботмастера эти шаблончики периодически обновляются, главное следить за ними. Кроме того, что можно удобно редактировать шаблоны парсинга их можно создавать самому. К примеру если нужно спарсить бэки яху или яндекс каталог или еще что нибудь, что можно спарсить.

В последних версиях хрефера появилась довольно интересная фича парсинга нескольких поисковых систем:

На самом деле эту функцию я опробовал только вчера, работает, больше сказать нечего. Если подобрать хорошие признаки для парсинга, то google classic вполне хватает.

Теперь пройдусь немного по вкладкам, расскажу что это такое.

1. Proxylist в этой вкладке собираются прокси для парсинга, настраивать особо ничего не нужно. Есть большая кнопка «start» после чего хрефер сам начинает отбирать рабочие проксики. В настройках есть возможность поменять источник проксей. По дефолту они беруться с сервера ботмастера, но если есть хорошие покупные прокси их тоже можно вставить в хрефер в настройках в соответствующую графу. Добавлю лишь, что стандартных проксей вполне достаточно для парсинга.

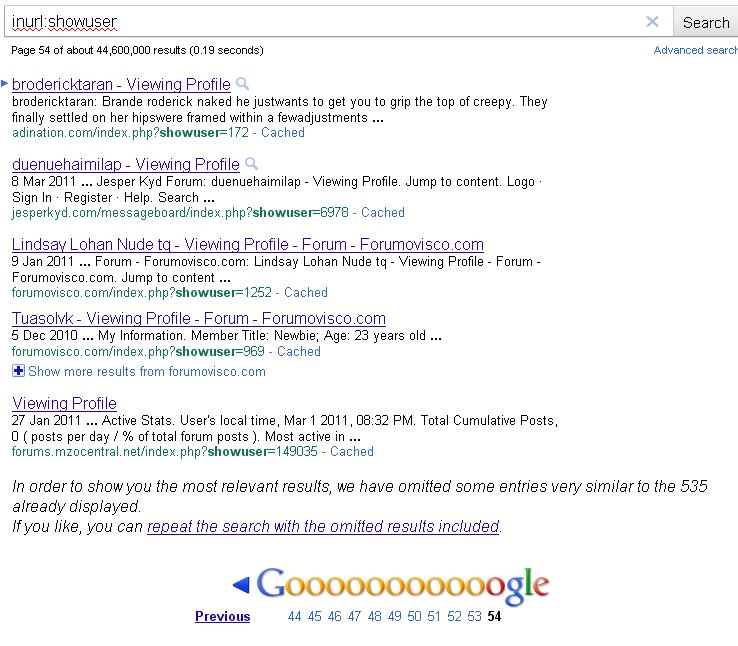

2. Words database и additive words database. Когда я только приобрел хрефер , я долго вдуплял зачем нужна эта вкладка. В ней какие то непонятные слова да и еще есть какие то непонятные слова в additive words database. Объясняю, в words database содержаться «дополнительные» слова для парсинга и работают они так. При парсинге в поисковик посылается запрос типа additive words database + 1 слово из words database потом, следующий запрос additive words database + 2 слово из words database. Тоесть, в Words database огромная куча слов, которая может встречатся на сайте. А additive words database содержаться конструкции, парсинга к примеру inurl:showuser и остальные подобные. Для чего все это было придумано. А потому что к по запросу inurl:showuser 44,600,000 results, google же показывает всего 54 страницы

С помощью такие запросов, из гугла можно вытянуть намного больше ссылок чем содержатся на 54 страницах. Опять же на примере: inurl:showuser огурец; inurl:showuser морковь; inurl:презик — три запроса в поисковик, результаты разные ссылки разные — нам счастье. И естественно в additive words database тоже не 1 конструкция. Вот и получается так парсить многотысячные базы.

С помощью такие запросов, из гугла можно вытянуть намного больше ссылок чем содержатся на 54 страницах. Опять же на примере: inurl:showuser огурец; inurl:showuser морковь; inurl:презик — три запроса в поисковик, результаты разные ссылки разные — нам счастье. И естественно в additive words database тоже не 1 конструкция. Вот и получается так парсить многотысячные базы.

3. Search Engines options & Filter В этой вкладке, тоже все довольно просто и понятно. В левых окошечках выбираются поисковые системы их язык. Справа домены, которые должна содержать ваша база (к примеру надо спарсить только сайты на .ru доменах ) и фильтры, а вот об этом немного поподробнее. Фильтры нужны для того чтобы повысить качество базы на выходе. Работают они по принципу «если есть кусок фильтра в ссылке» то значит ссылка удовлетворяет фильру и относится к форуму (если фильтр для форумов). Фильтры можно опять же создавать индивидуально, тоесть фильтры для форумов и гостевых книг будут отличаться. Лично я не пользуюсь фильтрами (их можно отключиться в настройках) поскольку, на мой взгляд лучше собрать получше базу признаков ( additive words database ).

4. Последняя вкладка — мультипоточность. В ней выставляются в сколько потоков парсить любимый гугл и в сколько потоков обновлять прокси (в этом не уверен, но перевод говорит об этом)

5. Пятым пунктом выделю некоторые плюшки хрефера. Одна из плюшек — это возможность проверки базы на PR, работает довольно странно, пробовал несколько раз проверять PR но как то он проверят по разному. Проверку можно осуществлять через прокси и через разные дата центры гугла. Вторая плюшка это так называемый bonus, по сути этой файл в который записываются все высокописаристые сайты, которые собирает хрефер. При включении этой функции работает медленее.

Хочется отметить что хрефер — это мощный комбайн, который можно настроить под свои цели и нужды. А можно не парится и нажав пару кнопок спарсить всю поисковую выдачу ВСЮ, но уйдет реально много времени.

p.s. 1 В конце хотелось бы сказать, что скоро, да думаю скоро выйдет еще один хороший обзор про CD (Content Downloader).

p.s. 2 База которую я продаю у себя в магазине скоро обновится. После того как я ее протестирую 🙂

p.s. 3 Статью писал sysoev.me

p.s. 4 Подписка